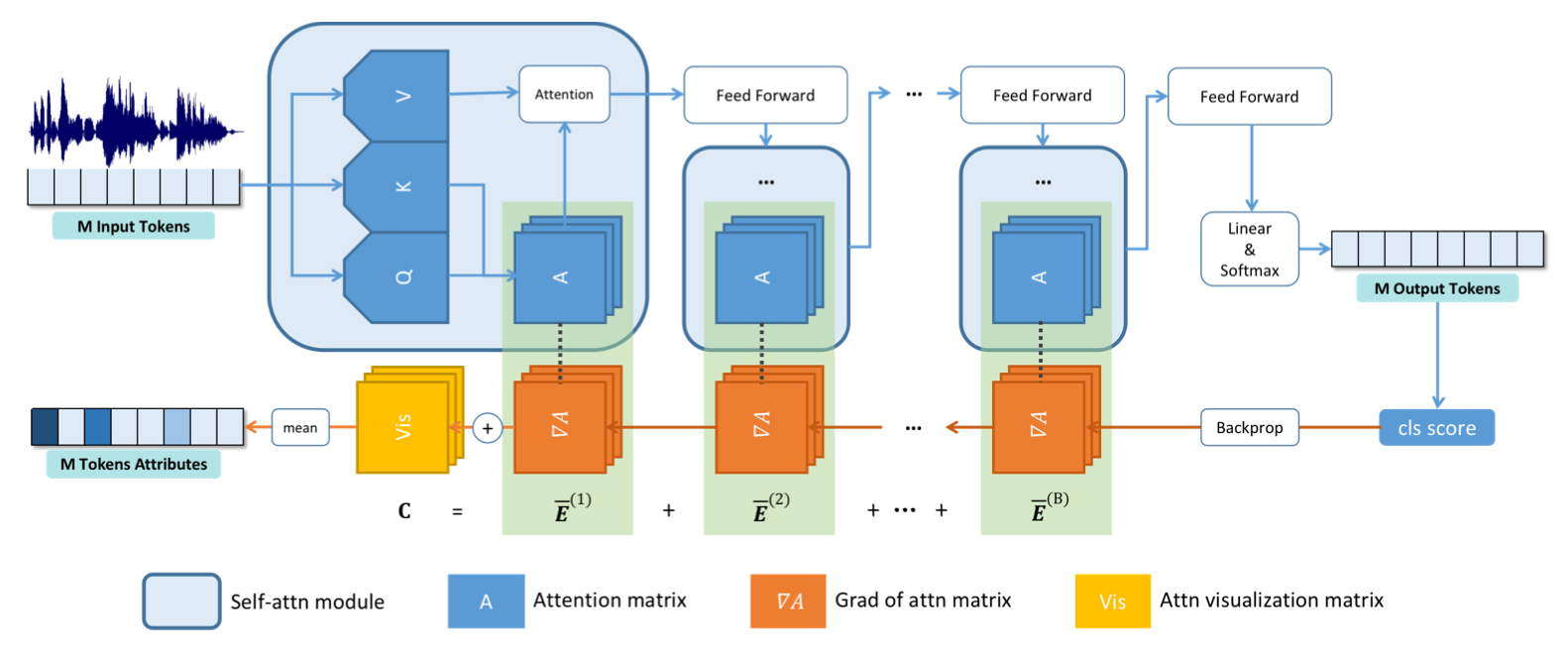

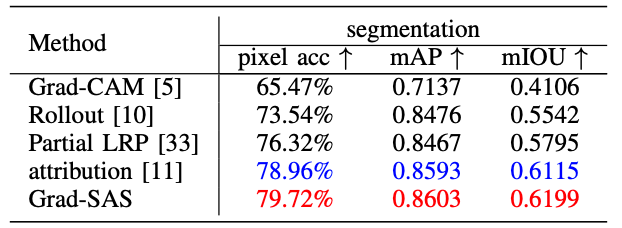

祝贺实验室团队博士生孙添力一篇论文“Explainability of Speech Recognition Transformers via Gradient-based Attention Visualization”被IEEE Transactions on Multimedia录用。现有的Transformer可解释性方法大多是基于模型信息流对自注意力进行融合,由于残差连接的存在,需要引入自注意力的初始值,而该值的存在会严重影响ASR这种多token输出任务的可解释性结果。经过严格的理论推导,我们提出了直接的矩阵相加,替代矩阵相乘,实现多层自注意力融合的方法Grad-SAS。这一方面简化了Transformer可解释性的理论,另一方面也降低了传统可解释性方法的时间复杂度,提升了方法的效率。大量实验显示,我们的方法在应用于图像任务时,与传统方法相比,能够在不影响准确性的情况下提升效率;在应用于ASR任务时,可以有效实现传统方法无法达到的可解释性效果。相应的可解释性结果有助于进一步理解ASR Transformer的工作原理。另外,基于本文的可解释性方法,提出了一种ASR Transformer的正则化训练方法,可以有效减轻训练过程中的过拟合,提升模型准确率。

本文方法

可解释性实验

模型识别准确率