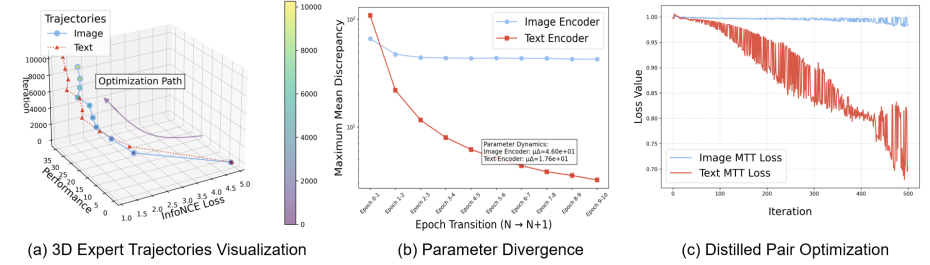

祝贺实验室博士生齐鼎一篇论文“Asynchronous Matching with Dynamic Sampling for Multimodal Dataset Distillation”被ICLR2026录用。

在多模态数据呈爆发式增长的时代,多模态数据集蒸馏 (Multimodal Dataset Distillation, MDD) 已成为实现视觉-语言模型高效训练的关键范式。与专注于单模态任务的传统数据集蒸馏方法不同,MDD 面临着独特的挑战:(i) 受限于特征空间错位和异步优化动态,异构多模态知识难以被有效蒸馏;(ii) 由于语义空间的广阔性与连续性,离散类别引导的缺失限制了合成数据的分布覆盖率与代表性。针对上述挑战,本文提出了异步匹配与动态采样 (Asynchronous Matching with Dynamic sampling, AMD) 框架。AMD 通过解耦图像与文本轨迹起始点的选择,实现了异步轨迹匹配。此外,本文引入了语义感知原型挖掘模块,该模块利用特征空间聚类识别代表性原型以替代随机初始化,从而显著提升了蒸馏样本的覆盖范围与代表性。大量实验表明,AMD 在 Flickr30k 和 COCO 数据集上均取得了卓越的蒸馏性能(例如,在 Flickr30k 200 pairs 设置下,IR@1、IR@5 和 IR@10 分别提升了 4.5%、9.6% 和 10.9%),且计算开销几乎可以忽略不计。

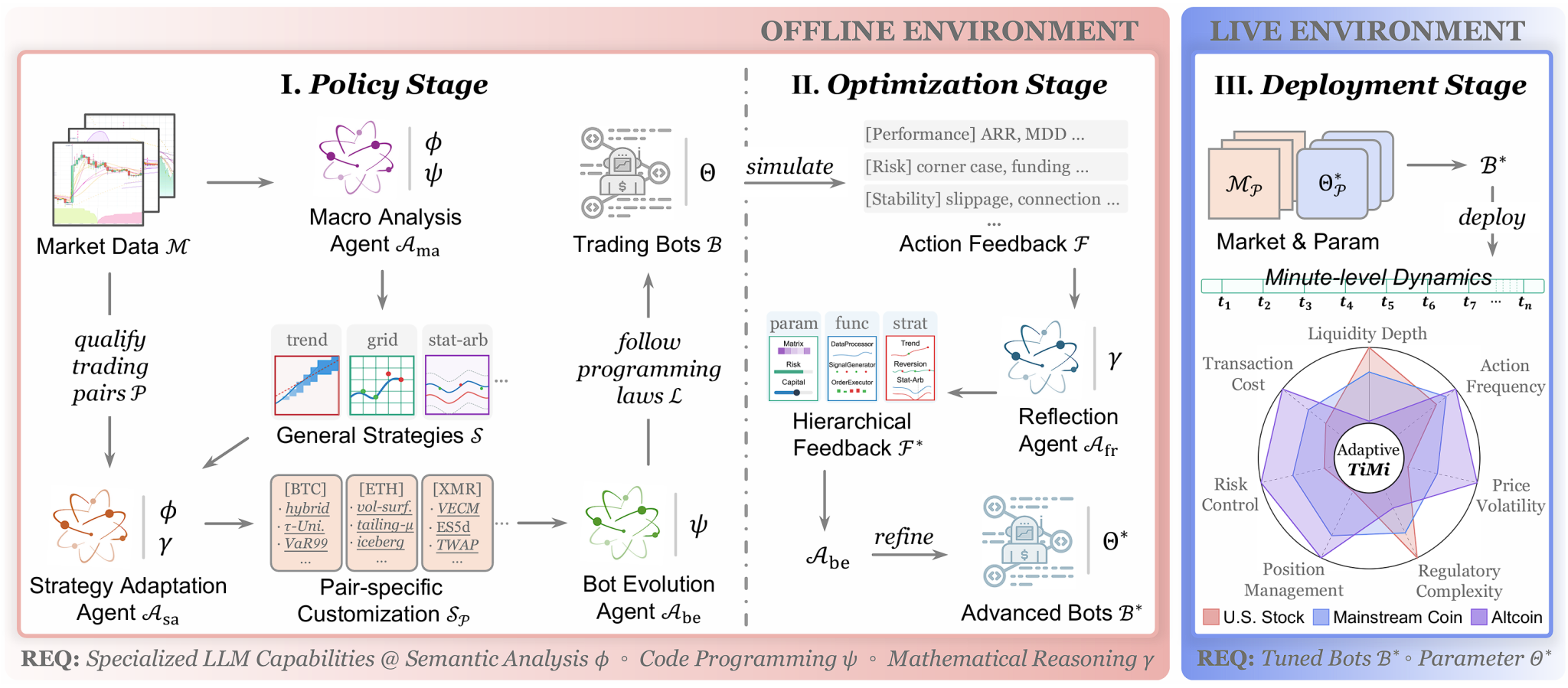

祝贺实验室博士生宋子帆一篇论文“Trade in Minutes! Rationality-Driven Agentic System for Ouantitative Financial Trading”被ICLR2026录用。

本工作提出了一种理性驱动的多智能体系统,旨在强调 mechanical rationality 以解决对非结构化噪声数据的依赖及受限于持续推理高延迟的瓶颈。该系统实现了策略开发与实时部署的架构解耦,充分利用基座模型在语义分析、代码编程及数学推理方面的专用能力,构建了包含宏观模式捕捉至微观标的定制的双层分析范式、用于程序化部署件实现的分层编程设计、以及由数学反思驱动的闭环优化机制。通过将仿真反馈转化为可解约束(如线性规划)进行参数与策略的迭代演进,我们的系统在 cross-pair 场景下展现出了可观的部署稳定性、分钟级执行效率与极端风险控制能力。

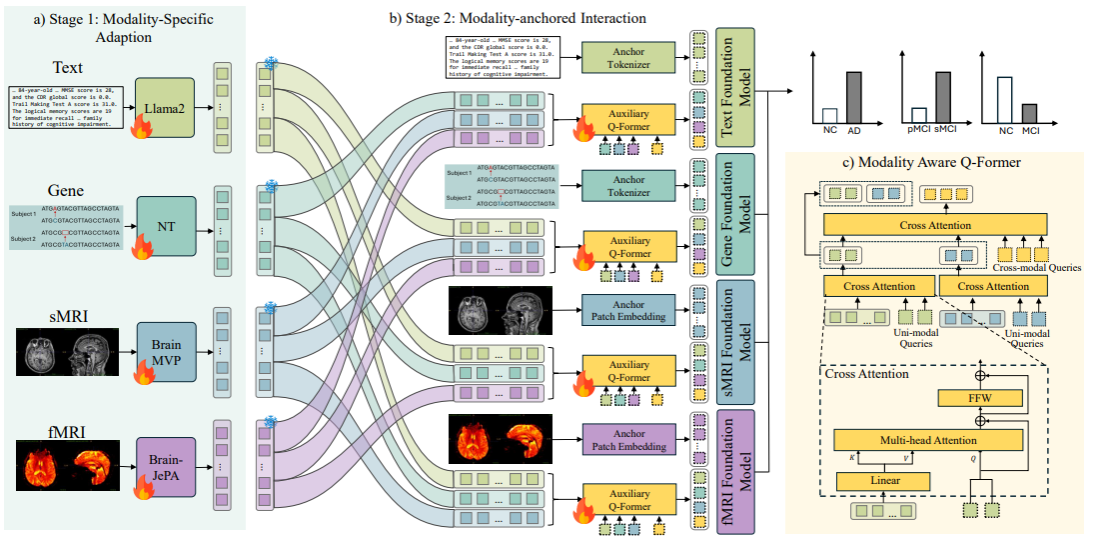

祝贺实验室硕士生顾文涛一篇论文“Joint Adaptation of Uni-modal Foundation Models for Multi-modal Alzheimer's Disease Diagnosis”被ICLR2026录用。

神经退行性疾病其精准诊断与进展预测依赖于对多模态患者数据的综合建模。随着神经科学与医学领域基础模型(foundation models)的快速发展,如何有效整合来自不同模态的基础模型以提升多模态疾病诊断性能,成为一项具有潜力但尚未充分探索的研究方向。现有方法在多模态融合过程中往往破坏各模态基础模型在大规模预训练中学习到的稳健表征,限制了模型性能与泛化能力。为此,本文提出一种基于模态锚定交互的多模态诊断框架,通过引入“锚定模态”与“辅助模态”的协同建模机制,实现多模态基础模型之间的高效交互。在该框架中,选定一个核心模态及其对应的基础模型作为锚定模型,其余模态作为辅助信息源。为在融合过程中保持锚定模型原有的表示空间结构,本文设计了模态感知模块,对辅助模态特征进行选择性映射,使其能够无缝嵌入锚定模型的特征空间,并与锚定模态特征进行联合建模。实验结果表明,该方法在多个神经退行性疾病的数据集与诊断任务中展现出良好的泛化能力。

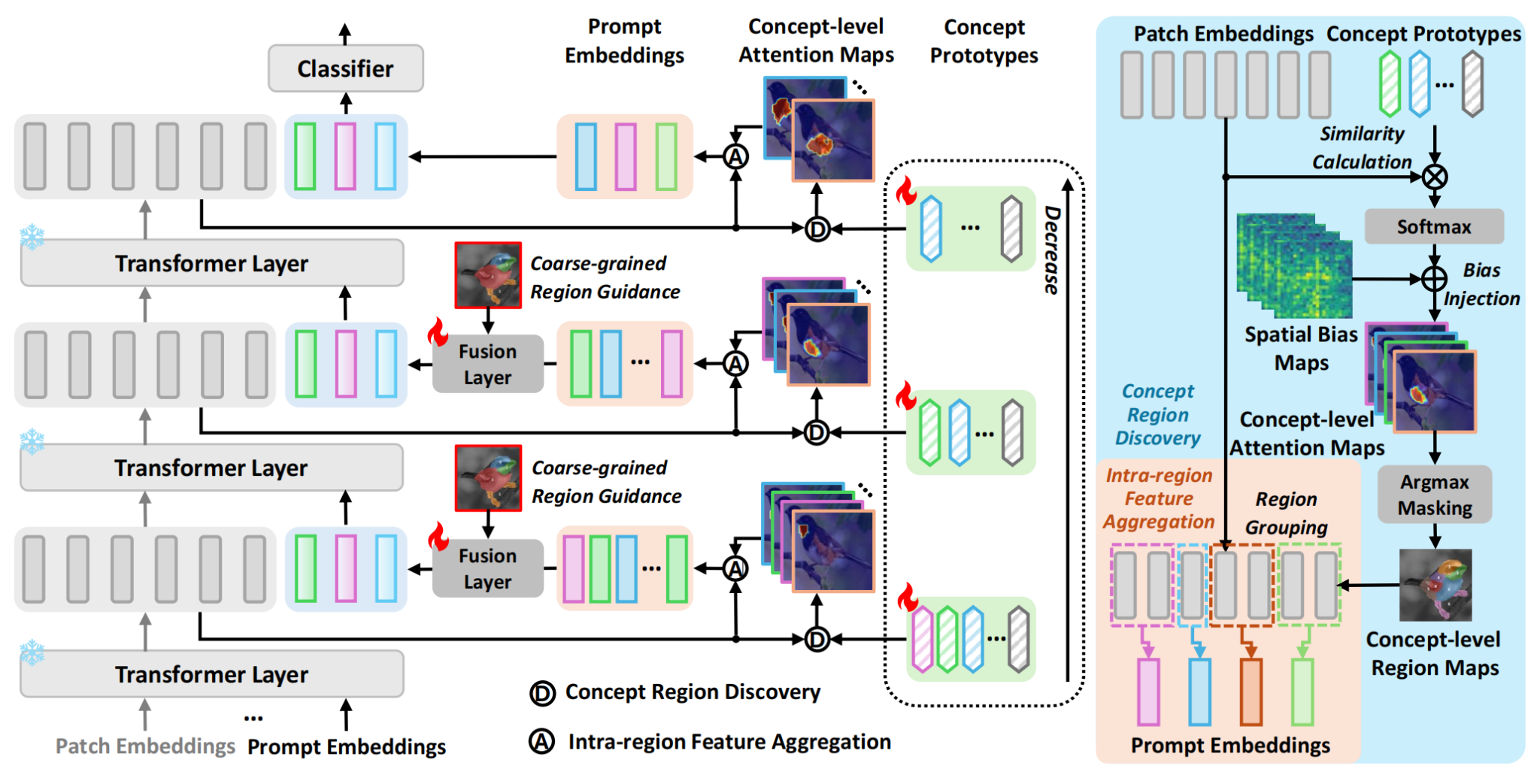

祝贺实验室硕士生王雨滨一篇论文“Exploring Interpretability for Visual Prompt Tuning with Cross-layer Concepts”被ICLR2026录用。

视觉提示调优技术虽能高效适配预训练视觉模型,但其提示向量通常为难以理解的“黑盒”,限制了在医疗等关键领域的可信应用。为此,我们提出首个可解释视觉提示调优框架IVPT。该框架引入跨层概念原型,将可学习的提示与人类可理解的视觉语义(如“鸟翼”、“车轮”)显式关联,并通过细粒度到粗粒度的跨层提示融合,模拟人类从局部到整体的视觉推理过程。实验表明,IVPT在多项细粒度分类与病理图像分析任务中,在保持高精度的同时,大幅提升了模型的透明度和决策可解释性。