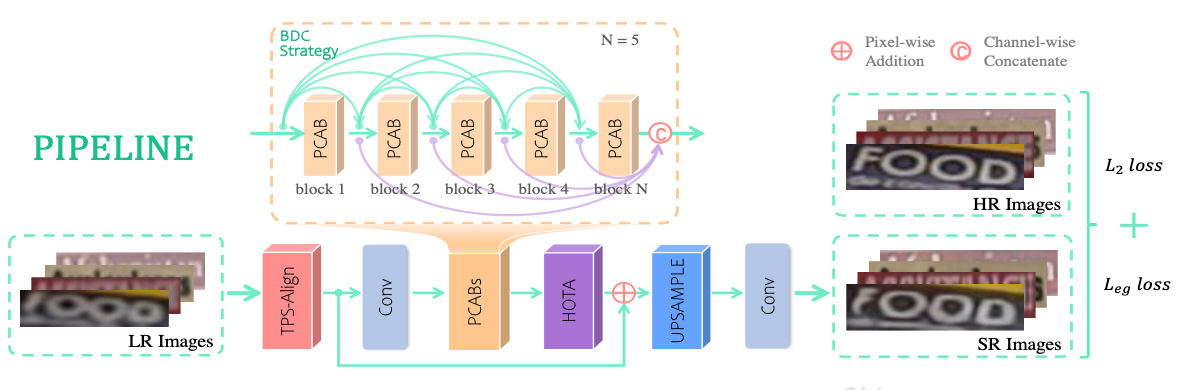

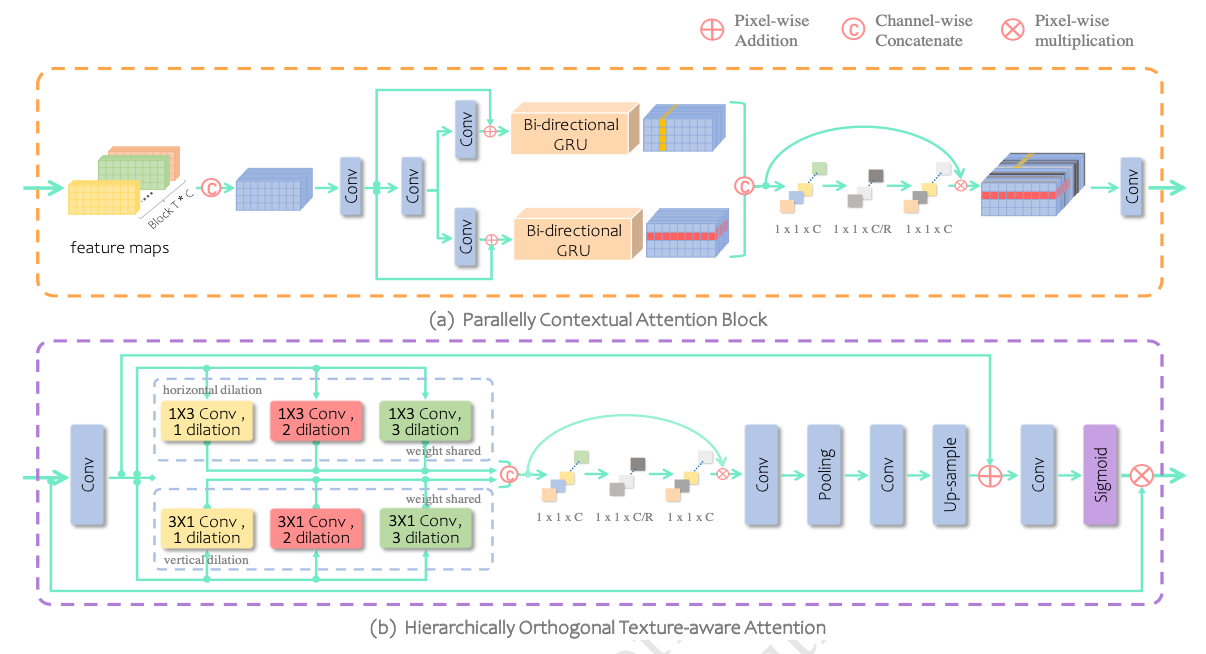

祝贺实验室团队硕士生冯舒扬一篇论文“Scene Text Image Super-Resolution via Parallelly Contextual Attention Network”被ACM Multimedia 2021录用。文章提出了一种并行上下文注意力网络(PCAN),能够有效地学习视觉上下文特征,并且有针对性的建模文本图像中的高频信息。首先,探索了文本SR在水平和垂直方向上的视觉上下文特征的重要性,由此设计了一个并行上下文注意力模块来自适应地选择视觉上下文特征中有助于文本图像超分辨率的关键信息。其次,提出了一个层次正交的纹理感知注意力模块和一个基于边缘引导的损失函数,分别以隐式和显式的手段帮助重建文本图像中的高频信息(重点是文本轮廓)。最后,我们在相关数据集上进行了大量的实验。若将此方法加入通用文字识别的流程中,能显著提升低分辨率图像上的文字识别准确率,优于 11 种最先进的超分辨率或文本超分辨率方法。最后,在此方法的应用层面做了新的拓展,在七个主流场景文本识别数据集上,尝试用此方法作为图像预处理步骤,抵抗对抗噪声对文字识别的影响,证明了它同时可以提高文本识别流程的安全性。